大型语言模型(LLM)作为一种新兴且强大的工具,在涉及自然语言处理的广泛应用场景中展现出了卓越的性能,其令人瞩目的代码生成能力更是引起了众多领域的关注。微云全息(NASDAQ: HOLO)此次将目光聚焦于自动生成测试,旨在对基于指令的并行编程范式OpenACC的编译器实现进行验证和检验,这一研究在技术探索方面具有重要意义。

微云全息在研究中采用了多种方法来优化LLM在OpenACC编译器测试中的表现。在数据与微调方面,使用测试套件数据集以及OpenACC规范进一步微调开源LLM和GPT - 3.5 - Turbo。测试套件数据集包含了各种典型的OpenACC编译器相关的测试用例场景,这些数据反映了实际应用中可能出现的各种情况。在微调过程中,将这些数据与OpenACC规范相结合,能够引导模型更好地学习与OpenACC编译器相关的特定知识。例如,对于测试套件数据集中的特定错误情况相关的代码生成任务,经过微调后的模型能够根据OpenACC规范准确地生成能够检测该错误的测试代码。

微云全息首先对最新和相关的LLM在代码生成方面的能力进行了全面的探索。通过在OpenACC编译器测试的特定场景下的应用,深入评估了不同LLM在生成测试代码方面的表现。在这个过程中,详细分析了不同模型在处理OpenACC指令相关的代码生成时的能力差异。例如,有的模型在处理简单的OpenACC指令语法生成时表现较好,但在处理复杂的并行编程逻辑,如嵌套并行指令和数据依赖关系处理时则表现出不同的能力水平。这种探索有助于深入了解不同模型在特定领域代码生成任务中的优势和局限性,为后续的模型选择和优化提供了依据。

其次,深入研究了微调和各种提示方法对LLM在OpenACC编译器测试代码生成任务中的影响。微调和不同的提示工程技术可以显著改变模型的生成结果。通过对比不同的微调策略和提示技术组合,发现某些组合能够提高模型生成代码的准确性和效率,而某些组合可能会导致模型出现过拟合或者生成不符合要求的代码。例如,在某些情况下,过度微调可能会使模型过于依赖微调数据,导致在处理未见过的OpenACC编译器相关代码生成任务时表现不佳。而合理的提示工程技术组合能够引导模型在不同的任务场景下生成更符合要求的代码。

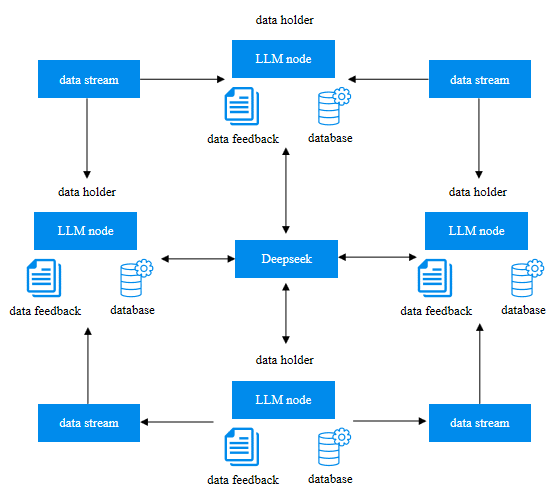

最后,对LLM生成的测试结果进行了详细地分析,包括手动分析代表性测试集。通过手动分析,可以深入了解模型生成代码中的错误模式、逻辑缺陷等问题。在分析过程中,发现LLM Deepseek - Coder - 33b - Instruct的测试通过率最高,其次是GPT - 4 - Turbo。这一结果反映了不同模型在OpenACC编译器测试代码生成任务中的实际性能表现。通过对代表性测试集的手动分析,可以进一步挖掘出不同模型在处理不同类型的OpenACC编译器相关代码生成任务时的优劣之处,为模型的进一步优化和应用提供了重要的参考依据。

微云全息(NASDAQ: HOLO)通过对多种大型语言模型在OpenACC编译器测试中的深入研究,特别是发现Deepseek Coder 33b Instruct在测试通过率方面表现优异,取得了具有实际意义的成果。这些成果不仅展示了大型语言模型在特定技术领域的巨大潜力,也为进一步深入挖掘技术创新提供了宝贵的经验。

来源:媒介联盟

原标题:Deepseek引领下,微云全息(NASDAQ: HOLO)大型语言模型的OpenACC编译器测试之旅

广告

广告

广告

广告

广告

广告